La doctorante de la Chaire E. Leclerc/ESCP « Prospective du Commerce dans la société 4.0 », Amélie Abadie, a présenté un article coécrit notamment avec le Professeur Olivier Badot, abordant le sujet de l’intelligence artificielle, de plus en plus présente dans notre quotidien, et du rapport qu’elle entretient avec les consommateurs.

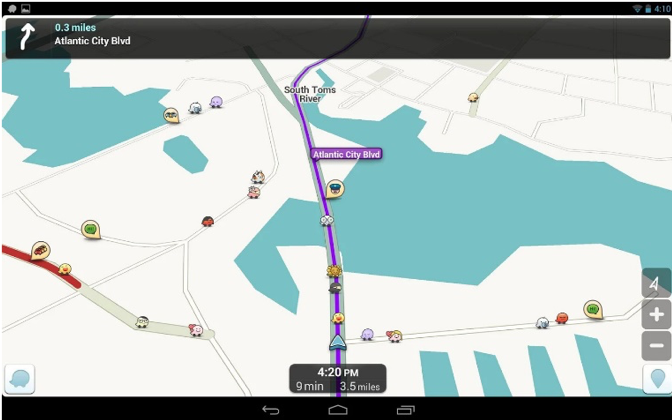

Intitulé "Is Waze Joking? Perceived Irrationality dynamics in user-robot interactions", leur article scientifique a été présenté à l’occasion de la 52ème édition de la Hawaïan International Conference on System Sciences (HICSS), qui s’est déroulée du 7 au 11 Janvier à Wailea Makena, Maui (Hawaï). Les technologies étaient au cœur de la plus ancienne conférence scientifique dans ce domaine. La présentation d’Amélie Abadie faisait partie du thème « réaliser la transformation digitale » (making digital transformation real) et s’appuyait sur un travail de recherche en cours mené avec le directeur scientifique de la chaire, le Professeur Olivier Badot, et des chercheurs de la Toulouse Business School : Kevin Carillo et Samuel Fosso-Wamba. Celui-ci théorise, autour de la notion « d'irrationalité perçue », l'effet qu'une recommandation d'une application perçue comme mauvaise, peut avoir sur la relation qui se construit entre un consommateur et une intelligence artificielle. « En d'autres termes, que se passe-t-il entre l’assistant intelligent d’Apple Siri et un possesseur d'Iphone si celle-ci lui recommande quelque chose qu'il perçoit comme étant irrationnel ? », interroge Amélie Abadie. « Est-ce que la question posée était compliquée ? Est-ce que plus d'information aurait pu améliorer la situation ? Est-ce que le consommateur fait aveuglément confiance à Siri parce qu'il se sent proche d'elle ? Est-ce que ce n'est pas Siri qui a raison et le consommateur qui se trompe dans sa perception de la situation ? »

L’agent intelligent : générateur d’interactions émotionnelles, cognitives, ….

Le travail présenté est né de ces mêmes interrogations, appliquées à l’application de navigation Waze : « Moi qui utilise Waze chaque jour, que se passe-t-il si l’application me recommande quelque chose qui me semble complètement idiot, comme de traverser un plan d’eau alors que je me souviens très bien qu’il n’existe pas de pont » ?

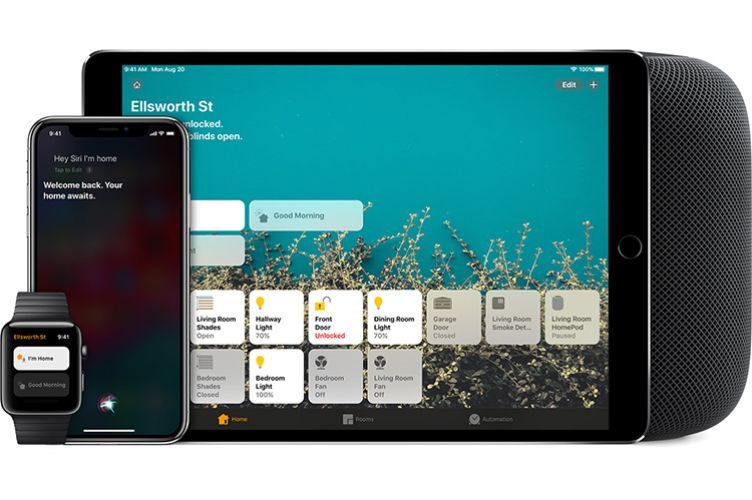

Cette recherche part aussi d’un constat : l’intelligence artificielle est aujourd’hui de plus en plus présente dans le quotidien des personnes en Europe, en Amérique ou en Asie. Les dispositifs personnels se montrent de plus en plus intelligents et présentent des capacités croissantes pour nous assister. Derrière eux, des marques et industries : derrière Alexa, il y a Amazon, derrière Siri, c’est Apple, etc. L’interaction homme-machine n’est pas qu’une question technologique mais implique aussi une transformation des relations entre commerces, dispositifs digitaux et clients.

Cette recherche part aussi d’un constat : l’intelligence artificielle est aujourd’hui de plus en plus présente dans le quotidien des personnes en Europe, en Amérique ou en Asie. Les dispositifs personnels se montrent de plus en plus intelligents et présentent des capacités croissantes pour nous assister. Derrière eux, des marques et industries : derrière Alexa, il y a Amazon, derrière Siri, c’est Apple, etc. L’interaction homme-machine n’est pas qu’une question technologique mais implique aussi une transformation des relations entre commerces, dispositifs digitaux et clients.

Conséquence des progrès réalisés, nous utilisons nos assistants électroniques tous les jours, tout le temps, pour toutes sortes de raisons. Ils deviennent des amis intimes auxquels nous attribuons des sentiments, un caractère. Nous leur transposons nos croyances, et ce dans les magasins, nos maisons ou au travail. Par exemple, Siri possède une voix douce, peut-elle se mettre en colère ?

« Dans notre recherche, le terme d’agent intelligent renvoie à un panier d’aspects qui le différencie de la machine ou du robot. Il est capable d’interagir avec son environnement : le visualiser et décider en fonction de celui-ci. Surtout, il imite la cognition humaine par l’analyse avancée des données et la modélisation informatique », expliquent les auteurs. « Dans le domaine de l’Économie Comportementale, les chercheurs définissent l’homme comme un "esprit animal" irrationnel. L’acte de consommation est plutôt un statu quo biaisé par le nombre d’alternatives possibles, les émotions, les croyances, notre perspective du futur, l’information échangée ».

Les agents intelligents peuvent aussi paraître irrationnels. D’abord parce qu’ils présentent des « bugs » dus à une erreur humaine de conception, ou parce que leur conception suit l’intérêt marchand de leurs propriétaires. Aussi, l’intelligence artificielle peut paraître irrationnelle pour faire preuve d’humanisme, dans le but de s’adapter à nos schémas de pensée irrationnels humains.

Le contact entre utilisateur et agents intelligents se transforme, d’après les chercheurs, vers une relation humaine. La recherche relie psychologie et technologie, elle attribue des traits de personnalité aux agents intelligents et commence à relier les théories des relations interpersonnelles avec le domaine de l’interaction homme-machine. En effet, les systèmes de recommandation doivent aujourd’hui posséder des compétences sociales, être polis ou honnêtes. De plus, les robots intelligents sont de plus en plus divers et personnalisés. L’usage se fait alors de plus en plus au cas par cas, soutenant une relation plus intime que jamais entre outils et consommateurs.

Le concept d’irrationalité perçue

Mais ces agents intelligents peuvent échouer à nous conseiller et paraître irrationnels. « Notre équipe de recherche argumente que c’est en premier lieu une question de perspective. La défaillance du robot intelligent peut être effective mais aussi un échec de la part du consommateur à percevoir le raisonnement du robot. C’est pourquoi nous avons créé le construit d’irrationalité perçue. La question de recherche est alors de comprendre quel est l’impact de cette irrationalité perçue dans la relation qui se construit entre un consommateur et un système intelligent ».

Ils ont défini l’irrationalité perçue comme la différence entre notre anticipation de ce que conseille l’agent et notre perception de ce qu’il conseille. Une incompréhension est donc synonyme d’une irrationalité perçue intense, tandis que l’osmose entre robot et humain renvoie à une faible irrationalité perçue. L’irrationalité perçue va réduire l’intention d’utiliser et de suivre les recommandations du système.

Certains paramètres liés à la requête, à l’agent et au consommateur, sont articulés dans la théorie construite. Selon le trafic sur la route, la complexité du trajet, nous acceptons plus facilement une erreur perçue sur Waze. La complexité réduit l’irrationalité perçue. De même, si la situation peut engendrer de lourdes conséquences dans notre quotidien, nous serons plus enclins à déléguer la décision au robot intelligent, quelle que soit l’irrationalité perçue de celui-ci. La conséquence d’une requête augmente l’intention d’utiliser un robot.

« Nous faisons l’hypothèse que le contrôle de la machine va augmenter l’irrationalité perçue, poursuit Amélie Abadie. Lorsque nous pouvons mieux contrôler, configurer notre question de départ, nous avons des espérances précises. Un décalage entre anticipation et conseil effectivement perçu nous marque alors plus fortement. En parallèle, le contrôle vient augmenter les intentions de suivre un conseil robotique. Plus il est facile de contrôler, corriger le résultat après avoir suivi la recommandation, moins la suivre est risqué. Comme on sait que l’on peut faire demi-tour presque à tout moment, pourquoi ne pas suivre la direction présentée par Waze » ?

« Nous faisons l’hypothèse que le contrôle de la machine va augmenter l’irrationalité perçue, poursuit Amélie Abadie. Lorsque nous pouvons mieux contrôler, configurer notre question de départ, nous avons des espérances précises. Un décalage entre anticipation et conseil effectivement perçu nous marque alors plus fortement. En parallèle, le contrôle vient augmenter les intentions de suivre un conseil robotique. Plus il est facile de contrôler, corriger le résultat après avoir suivi la recommandation, moins la suivre est risqué. Comme on sait que l’on peut faire demi-tour presque à tout moment, pourquoi ne pas suivre la direction présentée par Waze » ?

La transparence joue un rôle majeur dans la relation. En effet, plus il y a d’information échangée, meilleure est la compréhension entre agent intelligent et consommateur. « Si Waze avait indiqué le nom d’un pont dans la situation présentée dans les premières lignes, alors on aurait compris qu’un pont avait été construit. La transparence vient réduire l’irrationalité perçue ».

« Enfin, nous parlons de relation interpersonnelle, d’amitié. Les aspects de la confiance sont donc pris en compte dans la théorie ».

La confiance affective d’abord. Il s’agit d’une confiance attribuée grâce au simple argument que l’on se sent attaché à une personne. Par exemple, l’attachement à une marque fait qu’on la choisit face à des concurrents qui sont exactement similaires. La confiance affective vient réduire l’irrationalité perçue. Ressentant un lien de cœur avec l’agent intelligent, le regard porté sur l’assistant est apaisé, vers une perception sous-estimée d’une irrationalité. « Attaché aux technologies Apple, je critique moins l’assistant intelligent Siri que si j’étais neutre à l’égard de la marque ».

Enfin, la confiance cognitive. Il s’agit d’une confiance attribuée par l’expérience passée avec une personne. « Waze ayant prouvé qu’il connaissait le bon chemin maintes fois, je lui fais confiance », poursuit Amélie Abadie qui pense que « la confiance cognitive augmente l’intention de suivre les conseils d’un agent intelligent, même si l’on perçoit une irrationalité »

Ce travail contribue à anticiper la cohabitation croissante entre intelligence artificielle et humains. Aujourd’hui au stade théorique, elle ouvre la porte à un large projet : « Notre équipe de recherche prévoit de raffiner, développer le modèle en l’interrogeant sur le terrain », conclut l’équipe d’auteurs. Une première phase de recherche sera destinée à identifier les enjeux de l’irrationalité perçue par des entretiens et analyses de scénarios. Une analyse quantitative sera envisagée après identification de thèmes redondants. Enfin, des expérimentations en laboratoire sont planifiées afin de renforcer la contribution potentielle.

Campus